IA e assistenza sanitaria: cosa potrebbe andare molto male?

Nel "selvaggio west" dell'assistenza sanitaria con l'intelligenza artificiale, queste 4 cose potrebbero andare molto male. Il segreto dell'IA dietro la salute: i vostri dati

PAYPAL: Clicca qui

STRIPE: Clicca qui

In alternativa, è possibile effettuare un bonifico bancario (SEPA) utilizzando il nostro conto

Titolare del conto: Come Don Chisciotte

IBAN: BE41 9674 3446 7410

BIC: TRWIBEB1XXX

Causale: Raccolta fondi

Conna Craig – The Epoch Times/Epoch Health – 20 maggio 2023

L’intelligenza artificiale (IA) fa notizia e le recensioni sono contrastanti.

Sebbene gli Stati Uniti siano al primo posto nel mondo per gli investimenti nell’IA, gli americani rimangono scettici. Secondo un sondaggio globale di Ipsos (qui in PDF), “solo il 35% degli americani intervistati concorda sul fatto che i prodotti e i servizi che utilizzano l’IA presentano più vantaggi che svantaggi“. Tra i Paesi intervistati, l’America ha registrato una delle percentuali più basse di persone che si sono dichiarate d’accordo con questa affermazione.

L’industria privata ha superato il mondo accademico nella produzione di sistemi di IA all’avanguardia; allo stesso tempo, il numero di episodi di utilizzo non etico dell’IA è aumentato drasticamente, passando da 10 nel 2012 a oltre 250 nel 2021.

Il campo sta crescendo in quello che potrebbe essere definito un “selvaggio West” dell’IA. Secondo il rapporto AI Index dell’Università di Stanford, “l’IA è entrata nella sua era di diffusione; per tutto il 2022 e l’inizio del 2023, ogni mese sono stati presentati nuovi modelli di IA su larga scala“. Questi modelli includono Stable Diffusion, Whisper, DALL-E 2 e l’onnipresente ChatGPT. L’area con il maggior numero di investimenti? L’assistenza sanitaria.

Le possibilità dell’IA nell’assistenza sanitaria sembrano infinite. Tuttavia, è ancora in dubbio se l’IA sia promettente o pericolosa.

Intelligenza artificiale 101

Sebbene si parli molto di IA, l’intelligenza artificiale non è una novità. Il lavoro teorico “sull’apprendimento automatico” è attribuito alla ricerca di Alan Turing, iniziata nel 1935. Il termine “intelligenza artificiale” è apparso all’inizio degli anni ’50 ed è stato utilizzato in una proposta del 1955 per un progetto di ricerca estivo al Dartmouth College (qui in PDF). L’estate successiva, 10 scienziati si riunirono per studiare se le macchine potessero simulare l’apprendimento e la creatività umana. Le loro scoperte avrebbero cambiato il corso della scienza.

Una definizione di base dell’IA è “software utilizzato dai computer per imitare gli aspetti dell’intelligenza umana“. Sotto l’ombrello dell’IA ci sono specialità come il “machine learning” e il “deep learning”, che possono prendere decisioni senza l’aiuto dell’uomo.

Gli scienziati hanno utilizzato l’IA nella ricerca medica fin dagli anni Settanta. La tecnologia può analizzare grandi quantità di dati per fornire raccomandazioni terapeutiche personalizzate e identificare modelli e rischi che potrebbero non essere immediatamente evidenti all’occhio umano. Nelle mani giuste, l’IA potrebbe rivoluzionare l’assistenza medica.

Sybil, un’intelligenza artificiale che rileva il cancro ai polmoni

Un team di ricerca del Massachusetts Institute of Technology (MIT) ha collaborato con il Massachusetts General Hospital (MGH) di Boston e il Chang Gung Memorial Hospital di Taiwan per creare uno strumento di intelligenza artificiale che valuta il rischio di cancro ai polmoni. Introdotto nel gennaio 2023, “Sybil” utilizza una singola scansione TC a basso dosaggio per prevedere il cancro che si manifesterà da uno a sei anni, con un’accuratezza notevolmente elevata, fino al 94% in uno studio clinico. Nel Journal of Clinical Oncology, i ricercatori hanno riassunto i primi successi di Sybil: “Sybil è stato in grado di prevedere il rischio di cancro al polmone sia a breve che a lungo termine” e “ha mantenuto la sua accuratezza in diversi gruppi di pazienti provenienti dagli Stati Uniti e da Taiwan“.

Il tumore al polmone è il cancro più letale al mondo “perché è relativamente comune e relativamente difficile da trattare, soprattutto una volta che ha raggiunto uno stadio avanzato“, ha dichiarato il dottor Florian Fintelmann, medico-scienziato radiologo al MGH, professore associato di radiologia alla Harvard Medical School e parte del team di ricerca. Fintelmann ha sottolineato che il tasso di sopravvivenza a cinque anni è del 70% per la diagnosi precoce, ma scende al 10% per la diagnosi avanzata.

La capacità di Sybil di prevedere gli esiti del cancro può portare a una maggiore diffusione dello screening, soprattutto nelle popolazioni meno servite. Ciò è in linea con le indicazioni della Food and Drug Administration (FDA) statunitense per migliorare l’iscrizione agli studi clinici da parte dei membri delle comunità minoritarie.

Crescita esponenziale dell’approvazione di applicazioni di intelligenza artificiale da parte della FDA

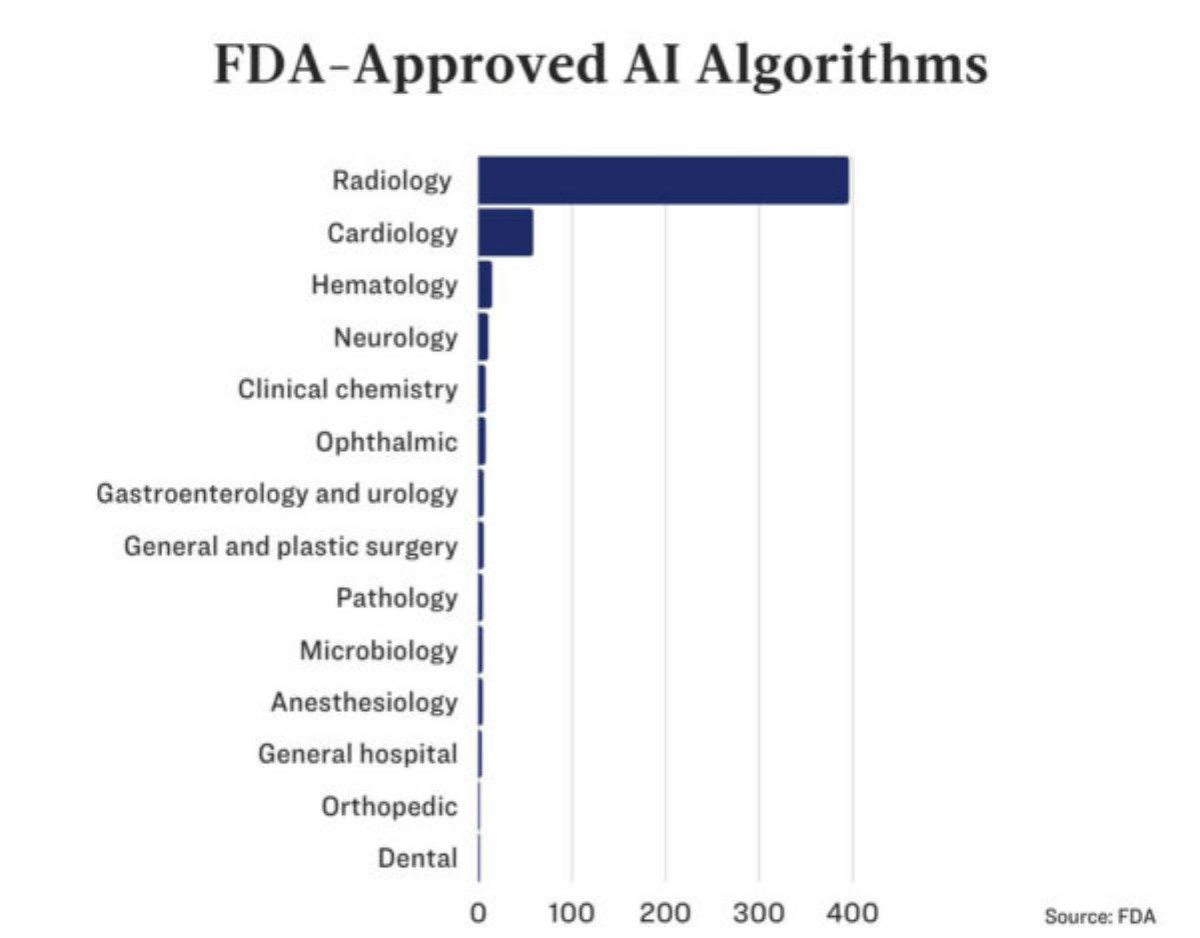

Mentre Sybil attende l’approvazione della FDA, sono già stati approvati 521 algoritmi di IA.

Tre quarti di questi riguardano la diagnostica per immagini e altri 56 sono applicazioni legate alla cardiologia.

Poiché l’apprendimento automatico si evolve con i nuovi dati, in futuro l’FDA richiederà che le applicazioni di IA includano piani di controllo delle modifiche predeterminati (PCCP). Di conseguenza, ha recentemente pubblicato una bozza di linee guida sui PCCP.

Questo per garantire che l’IA “possa essere modificata, aggiornata e migliorata in modo sicuro, efficace e rapido in risposta a nuovi dati“, ha dichiarato in un comunicato Brendan O’Leary, vicedirettore del Centro di eccellenza per la Salute digitale del Centro per i dispositivi e la salute radiologica dell’FDA.

Se la guida verrà approvata, gli sviluppatori potranno aggiornare i dispositivi di intelligenza artificiale senza presentare una nuova domanda alla FDA.

È probabile che, anche con l’aumento delle richieste di dati da parte della FDA, lo sviluppo di dispositivi e algoritmi di IA non subirà rallentamenti.

Cosa potrebbe andare storto?

L’intelligenza artificiale è stata creata per imitare il modo in cui gli esseri umani pensano, ragionano e risolvono i problemi. Gli esseri umani sono fallibili e hanno pregiudizi; tuttavia, l’IA potrebbe non essere migliore.

Dati inaffidabili generano rischi

Il giudizio dell’IA si basa sui dati che le vengono forniti. La “distorsione dei dati” si verifica quando un algoritmo viene addestrato con dati insufficienti o incompleti, il che porta a previsioni errate.

Mentre numerosi studi hanno affermato che l’intelligenza artificiale è in grado di valutare il cancro della pelle in modo più accurato rispetto ai medici umani, un gruppo di ricercatori ha deciso di sfidare un’applicazione di intelligenza artificiale.

I ricercatori hanno iniziato con 25.331 immagini di addestramento provenienti da due set di dati, uno da Vienna e l’altro da Barcellona, che comprendevano otto malattie della pelle. Poi hanno aggiunto immagini provenienti da Turchia, Nuova Zelanda, Svezia e Argentina, che non erano state utilizzate nei dati di addestramento e che includevano altre malattie della pelle.

L’intelligenza artificiale ha classificato in modo errato quasi la metà (47,1%) delle immagini non provenienti dai set di dati di addestramento. Secondo i ricercatori, ciò “porterebbe a un numero sostanziale di biopsie non necessarie se le attuali tecnologie di IA all’avanguardia venissero impiegate clinicamente“.

Anche l’IA più promettente richiede test clinici reali prima di essere adottata.

Non sempre il passato è un postulato valido

Come fanno gli sviluppatori di IA a misurare il successo dei loro algoritmi? In genere, conducono studi con serie di dati del passato.

Come ha scritto Eugenio Santoro dell’Istituto di Ricerche Farmacologiche Mario Negri, “molti di questi studi sono retrospettivi e si basano su insiemi di dati precedentemente assemblati, mentre pochi sono quelli prospettici condotti in contesti clinici reali e pochissimi sono quelli basati su studi clinici controllati randomizzati“.

Un robot che sussurra all’orecchio

Gli esseri umani possono essere influenzati dai dati generati da computer o IA, anche quando questi dati non sono corretti. In che misura, quindi, l’IA potrebbe influenzare i professionisti del settore medico?

In un esperimento condotto da ricercatori tedeschi e olandesi, 27 radiologi hanno letto 50 mammografie. Ai radiologi sono state fornite categorizzazioni (false) generate dall’intelligenza artificiale per le mammografie, metà delle quali erano errate (i radiologi sono stati inconsapevolmente influenzati dalle valutazioni generate dall’IA: “I radiologi esperti, quelli con più di 15 anni di esperienza in media, hanno visto la loro accuratezza scendere dall’82% al 45,5% quando la presunta IA suggeriva una categoria errata“.

I ricercatori scrivono che sono necessarie delle misure di salvaguardia per evitare questo tipo di pregiudizio, e una di queste è che dovremmo conoscere “il processo di ragionamento” dell’IA, cioè ciò che avviene nella cosiddetta “scatola nera”.

Il mistero della scatola nera

Il luogo teorico in cui si svolge tutto ciò che avviene tra l’input (dati) e l’output è chiamato “scatola nera”.

Poiché l’apprendimento automatico è in grado di auto-apprendere, parte di ciò che accade all’interno della scatola nera rimane misterioso, persino per i suoi creatori.

Nell’IA, l’accuratezza è tutto. L’idea prevalente è che per ottenere questa precisione, l’IA debba essere complicata e non interpretabile. Tuttavia, gli scienziati stanno iniziando a mettere in discussione questa idea.

Secondo un articolo pubblicato sulla Harvard Data Science Review, “il cosiddetto compromesso accuratezza-interpretabilità si rivela falso: i modelli più interpretabili spesso diventano più (e non meno) accurati“. Inoltre, spiegano gli autori, “quando gli scienziati capiscono cosa stanno facendo quando costruiscono modelli, possono produrre sistemi di IA che sono in grado di servire meglio gli esseri umani che si affidano a loro“.

Anche la scatola nera contribuisce alla sfiducia, soprattutto a causa della sua “natura altamente opaca o inspiegabile“. In un libro bianco pubblicato dalla Società Italiana di Radiologia Medica e Interventistica lo scorso maggio, gli autori hanno osservato: “Anche gli esperti ai massimi livelli possono avere difficoltà a comprendere appieno i modelli cosiddetti ‘black-box’“.

Gli autori del libro bianco fanno riferimento alla “IA spiegabile” come un aspetto importante dell’adozione della IA, invitando gli sviluppatori a passare da modelli “black box” a modelli “glass box”.

Non è nascosto solo ciò che accade all’interno della scatola: i dati di addestramento forniti agli algoritmi di IA potrebbero sorprendervi.

In fin dei conti, da chi provengono i dati?

Il modo in cui l’intelligenza artificiale apprende è modellato sul modo in cui gli esseri umani apprendono. Fin da piccoli impariamo dalle persone che ci circondano. Allo stesso modo, l’IA non esiste nel vuoto. Prima di poter fare la sua magia, ha bisogno di dati.

E questi dati provengono da voi e da me.

I nostri dati vengono raccolti in una miriade di modi. Se utilizzate un’applicazione per la salute online o indossate un dispositivo “intelligente”, il vostro fitness tracker potrebbe tenere traccia di ogni passo che fate e trasmettere questi dati a un’azienda che li raggruppa e li vende. Se controllate il meteo locale su uno smartphone, è probabile che abbiate attivato il rilevamento della posizione del telefono. Sapevate che l’applicazione tiene traccia di ogni luogo in cui andate e di quanto tempo ci passate e può dedurre da questi dati quale religione praticate, se votate o meno e persino la vostra età?

E i dati medici? La maggior parte degli americani conosce l’Health Insurance Portability and Accountability Act (HIPAA), che protegge la nostra privacy in relazione alle informazioni sanitarie.

Tuttavia, l’HIPAA presenta delle lacune. “Numerose applicazioni e siti web che non rientrano nell’ambito di applicazione dell’HIPAA, ovvero le ‘entità coperte’, sono del tutto liberi di raccogliere, aggregare, vendere, concedere in licenza e condividere le informazioni sanitarie degli americani sul mercato aperto“, ha spiegato Justin Sherman, membro anziano e responsabile della ricerca presso il progetto di intermediazione dei dati della Duke University Sanford School of Public Policy, nella sua testimonianza scritta per la Commissione per l’Energia e il Commercio della Camera degli Stati Uniti.

Alcuni dei dati provengono direttamente dagli ospedali. Secondo VentureBeat, “Google mantiene una partnership di ricerca decennale con la Mayo Clinic che garantisce all’azienda un accesso limitato a dati anonimizzati che può utilizzare per addestrare gli algoritmi“.

In quella che definisce “una mossa per democratizzare la ricerca sull’intelligenza artificiale e la medicina“, l’Università di Stanford gestisce “il più grande archivio gratuito al mondo di set di dati di imaging medico, annotati e pronti per l’AI“.

“Ciò che guida questa tecnologia, che si tratti di un chirurgo o di un’ostetrica, sono i dati“, ha dichiarato Matthew Lungren, condirettore del Centro per l’Intelligenza Artificiale nella Medicina e nell’Imaging (AIMI) di Stanford e assistente alla cattedra di radiologia della stessa università. “Vogliamo ribadire l’idea che i dati medici sono un bene pubblico e che dovrebbero essere aperti al talento dei ricercatori di tutto il mondo“.

È davvero questo che vogliamo: che i nostri dati medici siano un “bene pubblico”?

E dopo, robot?

Chi avrebbe potuto immaginare che l’IA sarebbe passata dalla fantascienza alla conversazione a tavola in un batter d’occhio? Di sicuro strumenti basati sull’IA come ChatGPT hanno reso l’IA ampiamente accessibile.

Mentre alcuni chiedono una moratoria sullo sviluppo dell’IA, altri avanzano rapidamente. Prevedere come saranno i prossimi cinque anni nel campo dell’IA è quasi impossibile. Ma non chiedetelo a un robot: non può prevedere il futuro.

Almeno, non ancora.

![conna_craig]() Conna Craig, laureata presso l’Harvard College, è una ricercatrice e scrittrice che si occupa di politiche pubbliche, salute e infanzia. Ha fornito consulenza ai responsabili di due amministrazioni della Casa Bianca.

Conna Craig, laureata presso l’Harvard College, è una ricercatrice e scrittrice che si occupa di politiche pubbliche, salute e infanzia. Ha fornito consulenza ai responsabili di due amministrazioni della Casa Bianca.

Scelto e tradotto (IMC) da CptHook per ComeDonChisciotte

Pro-memoria: leggere attentamente ed assicurarsi di aver chiaramente compreso le Regole per i commenti

CANALE YOUTUBE: https://www.youtube.com/@ComeDonChisciotte2003

CANALE RUMBLE: https://rumble.com/user/comedonchisciotte

CANALE ODYSEE: https://odysee.com/@ComeDonChisciotte2003

CANALI UFFICIALI TELEGRAM:

Principale - https://t.me/comedonchisciotteorg

Notizie - https://t.me/comedonchisciotte_notizie

Salute - https://t.me/CDCPiuSalute

Video - https://t.me/comedonchisciotte_video

CANALE UFFICIALE WHATSAPP:

Principale - ComeDonChisciotte.org