PAYPAL: Clicca qui

STRIPE: Clicca qui

In alternativa, è possibile effettuare un bonifico bancario (SEPA) utilizzando il nostro conto

Titolare del conto: Come Don Chisciotte

IBAN: BE41 9674 3446 7410

BIC: TRWIBEB1XXX

Causale: Raccolta fondi

Vi proponiamo il primo di due articoli sul tema dell’Intelligenza Artificiale (e sui pericoli potenziali connessi al suo utilizzo), vista da due diverse angolazioni anche se entrambi gli autori hanno una formazione informatica. Più una sviluppatrice software la prima, artista eclettica ed ottima scrittrice, esperto di I.A. il secondo, poi approdato in politica; più appassionata e lunga la perorazione di Tessa Lena sull’importanza dei valori umani, più distaccata e (relativamente) tranquillizzante l’analisi del congressista USA Jay Obernolte (laurea in I.A.). Ciò non toglie che, a mio parere, entrambi traccino un quadro con molti punti di contatto. Ai lettori il giudizio.

Tessa Lena – mercola.com – 22 aprile 2023

Questa storia riguarda le implicazioni degli ultimi sviluppi della tecnologia legale. Prima di iniziare, vorrei porre una domanda e lasciarla lì, in modo da tenerla a mente mentre ci immergiamo nelle ultime meraviglie del mondo dell’intelligenza artificiale. La domanda è: qual è il senso della nostra esistenza come esseri umani sulla Terra?

Il chatbot ha superato l’esame di abilitazione all’esercizio della professione forense

Si dice che l’ultima IA supportata da Microsoft abbia superato l’esame universale di abilitazione alla professione forense, un esame che gli avvocati degli Stati Uniti devono superare per ottenere l’abilitazione alla professione. Non solo l’ha superato, ma il suo punteggio “è rientrato nel top 10% dei partecipanti al test”.

Questo software di intelligenza artificiale, realizzato dal partner di Microsoft OpenAI, si chiama “GPT-4”. Si tratta di un aggiornamento del GPT-3.5, su cui si basa il famoso programma ChatGPT. Nel caso siate curiosi, “GPT” è l’acronimo di “Generative Pre-trained Transformer”, un modello di linguaggio informatico che utilizza il “l’apprendimento profondo” per produrre testo.

L’apprendimento profondo consiste nel setacciare vaste quantità di dati, estrarre algoritmicamente caratteristiche significative di diverso tipo e poi riassumerle in modo da far sembrare che il computer “capisca”.

Questo software rientra nella definizione di “IA generativa”, ovvero quel tipo di IA che va oltre l’analisi di grandi quantità di dati e la produzione di un riassunto e che è in grado di generare i propri risultati “creativi” sulla base dei dati analizzati.

Secondo il rapporto tecnico sul GPT-4 di OpenAI, il programma è stato testato “su una serie diversificata di test di prestazione (benchmark), compresa la simulazione di esami originariamente progettati per gli esseri umani“.

Un intermezzo

Posso approfittare di questa occasione per esprimere il mio fastidio per la diffusione dell’uso hipster della parola “umani” al posto di “persone”, come se ci sarà mai un momento in cui i robot diventeranno senzienti e cominceranno a partecipare alla società non come un tipo di tecnologia nelle mani di chi comanda, ma come esseri viventi a tutti gli effetti?

Naturalmente questo non accadrà mai (anche se i detentori dei brevetti possono far finta di crederlo). È un’assurdità e una finzione. Ma chiamare le persone “esseri umani” introduce una nuova visione di noi stessi attraverso occhi meccanici esteriorizzati. È l’ennesimo trucco magico dei pazzi in poltrona per disconnetterci dalla nostra personalità innata e dalla nostra anima. Aiuta anche i tiranni a creare “cittadini robot” e a dare loro “diritti“.

I “cittadini robot” possono persino includere “attori finanziari”, per giustificare la frode! E quando le persone reali si lamenteranno dell’assurdità di questa situazione, basata sul fatto che i robot non sono effettivamente “umani”, saranno accusate di avere una sorta di fobia.

L’uso di “umani” al posto di “persone” per descrivere tutti noi rende l’inganno un po’ più facile, perché queste macchine o prodotti software sono persone? Ovviamente non lo sono. Sappiamo che non sono persone. Ma sono forse un po’ simili agli esseri umani? Cercano di essere umani? Vogliono essere umani? Meritano di essere umani? Non pensate che meritino almeno dei diritti simili a quelli umani? ecc.

Torniamo al tema dell’IA che supera l’esame di abilitazione all’esercizio della professione forense

In ogni caso, secondo OpenAI, l’azienda ha usato le precauzioni necessarie per garantire che il prodotto IA non si limitasse a riprodurre meccanicamente le risposte corrette già note alle domande già note dell’esame di stato. Nelle loro stesse parole: “non abbiamo fatto alcuna formazione specifica per questi esami.

Una minoranza dei problemi presenti negli esami è stata vista dal modello durante l’addestramento; per ogni esame abbiamo eseguito una variante con queste domande rimosse e abbiamo riportato il punteggio più basso tra i due. Riteniamo che i risultati siano rappresentativi.

Gli esami sono stati ricavati da materiali disponibili pubblicamente. Le domande d’esame comprendevano sia domande a scelta multipla sia domande a risposta libera; abbiamo progettato prompt separati per ogni formato e le immagini sono state incluse nell’input per le domande che lo richiedevano.

L’impostazione della valutazione è stata progettata in base alle prestazioni su una serie di esami di convalida, e riportiamo i risultati finali sugli esami di prova non ancora svolti. I punteggi complessivi sono stati determinati combinando i punteggi delle domande a scelta multipla e a risposta libera, utilizzando metodologie pubblicamente disponibili per ogni esame.

In un esame di abilitazione simulato, il GPT-4 ottiene un punteggio che rientra nel primo 10% dei partecipanti al test. Ciò contrasta con il GPT-3.5, che ottiene un punteggio inferiore al primo 10%”. Ecco i punteggi uniformi dell’esame di stato e i risultati del test LSAT, secondo il Rapporto tecnico GPT-4:

Esame di stato uniforme (MBE+MEE+MPT)

GPT-4: 298 / 400 (circa 90° percentile)

GPT-4 (senza visione): 298 / 400 (circa 90° percentile)

GPT-3.5: 213 / 400 (circa 10° percentile)

LSAT

GPT-4: 163 (circa 88° percentile)

GPT-4 (senza visione): 161 (circa 83° percentile)

GPT-3.5: 149 (circa 40° percentile)

Ecco cosa dice una recensione mainstream del software, scritta dal dottor Lance Eliot e pubblicata su law.com:

Il superamento dell’esame di abilitazione uniforme simulato implica o dimostra che il GPT-4 è legalmente capace e pienamente pronto a svolgere compiti legali alla pari con gli avvocati umani?

La risposta è un secco no, e cioè che, nonostante le allusioni o le implicazioni ammiccanti, tutto ciò che si può ragionevolmente affermare è che il GPT-4 è stato in grado di utilizzare il suo ampio pattern-matching computazionale di parole correlate ad altre parole per ricavare con successo le risposte agli esami presentati.

Il mio commento: credo sia importante sottolineare il fatto che la componente “ammiccante” è una parte importante del mito dell’IA. Dobbiamo ricordarlo quando si tratta di tutto il “lavoro” dell’IA, non solo dei compiti che le persone svolgono nei loro percorsi di carriera attualmente ancora prestigiosi. È possibile che quando i signori supremi hanno ideato i loro trasportatori e la “gestione dei sistemi” ci abbiano sbrigativamente?! Torniamo all’analisi del dottor Eliot:

“Come ho affermato nel mio precedente articolo intitolato ‘I modi migliori per utilizzare l’IA generativa negli studi legalei’, occorre prestare attenzione a non esagerare con i risultati che l’IA generativa può raggiungere. Inoltre, il paragone del GPT-4 con “prestazioni di livello umano” sa di antropomorfizzazione dell’IA. Si tratta di una china sdrucciolevole e pericolosa che porta le persone a credere che l’IA attuale sia senziente o abbia capacità simili a quelle umane.

L’IA generativa, come il GPT-4, è particolarmente utile come ausilio per gli avvocati e può essere un enorme passo avanti nell’esecuzione di compiti legali. Detto questo, affidarsi esclusivamente all’IA generativa per le attività legali è sbagliato e scorretto.

Il punto chiave per gli avvocati è che dovrebbero prendere in seria considerazione la possibilità di sfruttare l’IA generativa come il GPT-4. Non c’è dubbio. GPT-4 è ancora più utile agli avvocati di ChatGPT. Ho ripetuto più volte che gli avvocati e gli studi legali che utilizzano l’IA generativa supereranno gli avvocati e gli studi che non la utilizzano”.

IA generativa

Parliamo per un attimo di IA generativa. Ecco cosa dice Reuter’s:

“L’intelligenza artificiale generativa è diventata un’espressione di moda quest’anno, catturando la fantasia del pubblico e scatenando una corsa tra Microsoft (MSFT.O) e Alphabet (GOOGL.O) per lanciare prodotti con una tecnologia che credono cambierà la natura del lavoro.

L’applicazione di IA generativa più famosa è ChatGPT, un chatbot che OpenAI, supportata da Microsoft, ha presentato alla fine dello scorso anno. L’intelligenza artificiale che lo alimenta è nota come un modello linguistico di grandi dimensioni, perché riceve una richiesta di testo e da questa scrive una risposta simile a quella umana”.

GPT-4, un modello più recente che OpenAI ha annunciato questa settimana, è ‘multimodale’ perché è in grado di percepire non solo il testo ma anche le immagini. Il presidente di OpenAI ha dimostrato martedì come sia in grado di scattare una foto di una bozza manuale per un sito web che voleva costruire, e di generarne uno reale”.

Ecco il mio passaggio preferito: “I ricercatori di cybersicurezza hanno anche espresso la preoccupazione che l’IA generativa possa consentire ai cattivi attori, persino ai governi, di produrre molta più disinformazione di prima“. Oh no, governi che diffondono disinformazione? Impossibile. Non è mai successo nella storia dell’umanità. Almeno, non il nostro governo. Non qui e non ora, e non contro di noi (fiuuu). Un breve video esplicativo della Reuters (narrato da una IA?).

Attenzione al linguaggio capovolto dell’IA

Una delle cose a cui prestare attenzione nei discorsi sull’IA è l’uso della parola “danno”. Che cos’è il “linguaggio dannoso”? A livello intuitivo, lo sappiamo (gli appelli alla violenza o all’abuso di minori, per esempio, sono in realtà un linguaggio dannoso) – ma nel contesto ufficiale, robotico, il “linguaggio dannoso” è qualsiasi cosa si dica in un determinato giorno.

In un’immaginaria società onesta, in una società in cui i leader non cercherebbero di manipolare il linguaggio e la testa delle persone, il desiderio di introdurre controlli severi su ciò che può uscire dalla bocca di un robot potrebbe essere un obiettivo neutrale e nobile. Dopotutto, si tratta di un robot. Ma non viviamo in una società onesta e i leader stanno già cercando di etichettare ogni “pensiero sbagliato” come “discorso d’odio”.

Quindi, naturalmente, man mano che la tendenza procede verso l’IA, e man mano che l’IA sostituisce gli educatori e il processo decisionale burocratico, le persone che devono affrontare la censura potrebbero essere sempre più schiacciate nella tortura di “parlare alla mano”. Una mano meccanica.

Quindi, naturalmente, man mano che la tendenza procede verso l’IA, e man mano che l’IA sostituisce gli educatori e il processo decisionale burocratico, le persone che devono affrontare la censura potrebbero essere sempre più schiacciate nella tortura di “parlare alla mano”. Una mano meccanica.

Ho pensato molto alla trasformazione del linguaggio in arma e alle interazioni automatizzate. Nella mia intervista con il dottor Bruce Dooley, abbiamo discusso sulla trasformazione in arma, nel campo d ella medicina, della parola “danno”, da parte della Federation of State Medical Boards. Nel mio articolo del 2022, “Chi è il terrorista?” ho scritto delle idee sul danno e sulla disinformazione avanzate dal DHS (Department of Homeland Security, cioè Ministero dell’Interno, N.d.T.) l’anno scorso. E qualche anno prima della Covid, ho scritto un saggio intitolato “Amore e automazione: il tocco inquietante di una madre meccanica“:

“I difensori dell’efficienza in genere cercano di imporla agli altri, pur permettendo a se stessi di rimanere umani e liberi di muoversi come desiderano. Un esempio famoso è il modo in cui personaggi del calibro di Steve Jobs e Bill Gates limitano l’accesso dei propri figli alla tecnologia, mentre dicono al resto del mondo che la tecnologia è universalmente e onnipresentemente fantastica.

I proprietari di fabbriche impongono volentieri l’efficienza agli ex artigiani indipendenti e ai loro discendenti. I manager degli uffici impongono l’efficienza agli schiavi degli uffici. I produttori di software vendono efficienza alla popolazione in generale. Ma nei loro stessi panni, i venditori di efficienza amano guardare il cielo e annusare i fiori”.

Cosa si può fare con l’intelligenza artificiale in campo legale?

A partire da questo momento, l’intelligenza artificiale può svolgere il lavoro che di solito viene svolto da paralegali e avvocati junior. Può personalizzare documenti basati su modelli, come contratti e lettere. È in grado di esaminare rapidamente vaste pile di documenti e di riassumere il caso da sottoporre all’esame di avvocati più esperti. Può anche redigere bozze di documenti legali, citando le leggi e i precedenti applicabili.

Secondo un’analisi della Brookings Institution, nel settore legale l’intelligenza artificiale può occuparsi di alcuni delle attività più dispendiose in termini di più tempo:

“Consideriamo uno dei compiti più lunghi nelle controversie legali: estrarre la struttura, il significato e le informazioni salienti da un’enorme serie di documenti prodotti durante l’esibizione delle prove. L’intelligenza artificiale accelererà enormemente questo processo, svolgendo in pochi secondi un lavoro che senza l’intelligenza artificiale potrebbe richiedere settimane. Si pensi alla stesura delle mozioni da presentare in tribunale.

L’intelligenza artificiale può essere utilizzata per produrre molto rapidamente le bozze iniziali, citando la giurisprudenza pertinente, avanzando argomentazioni e confutando (nonché anticipando) le argomentazioni avanzate dall’avvocato della controparte. Il contributo umano sarà comunque necessario per produrre la bozza finale, ma il processo sarà molto più veloce con l’IA.

Più in generale, l’IA renderà molto più efficiente per gli avvocati la stesura di documenti che richiedono un alto grado di personalizzazione, un processo che tradizionalmente impegna una quantità significativa del loro tempo.

Tra gli esempi si possono citare i contratti, i numerosi tipi di documenti che vengono depositati in tribunale durante le controversie, le risposte agli interrogatori, i riassunti per i clienti dei recenti sviluppi di una questione legale in corso, i supporti visivi da utilizzare in tribunale e le proposte per acquisire nuovi clienti.

L’intelligenza artificiale potrebbe essere utilizzata anche durante un processo per analizzarne la trascrizione in tempo reale e fornire suggerimenti agli avvocati per aiutarli a scegliere le domande da porre ai testimoni”.

“DoNotPay”

Uno dei primi prodotti di AI legal tech più popolari, definito “il primo avvocato robot del mondo”, è stato creato nel 2015 da Josh Browder, il fondatore di DoNotPay. Questo particolare software è stato progettato per aiutare le persone a scrivere risposte e lettere efficaci per ricorrere contro multe emesse ingiustamente, cancellare gli abbonamenti e così via. Una volta che la voce si è sparsa, l’azienda è riuscita a ricevere importanti finanziamenti da parte degli investitori.

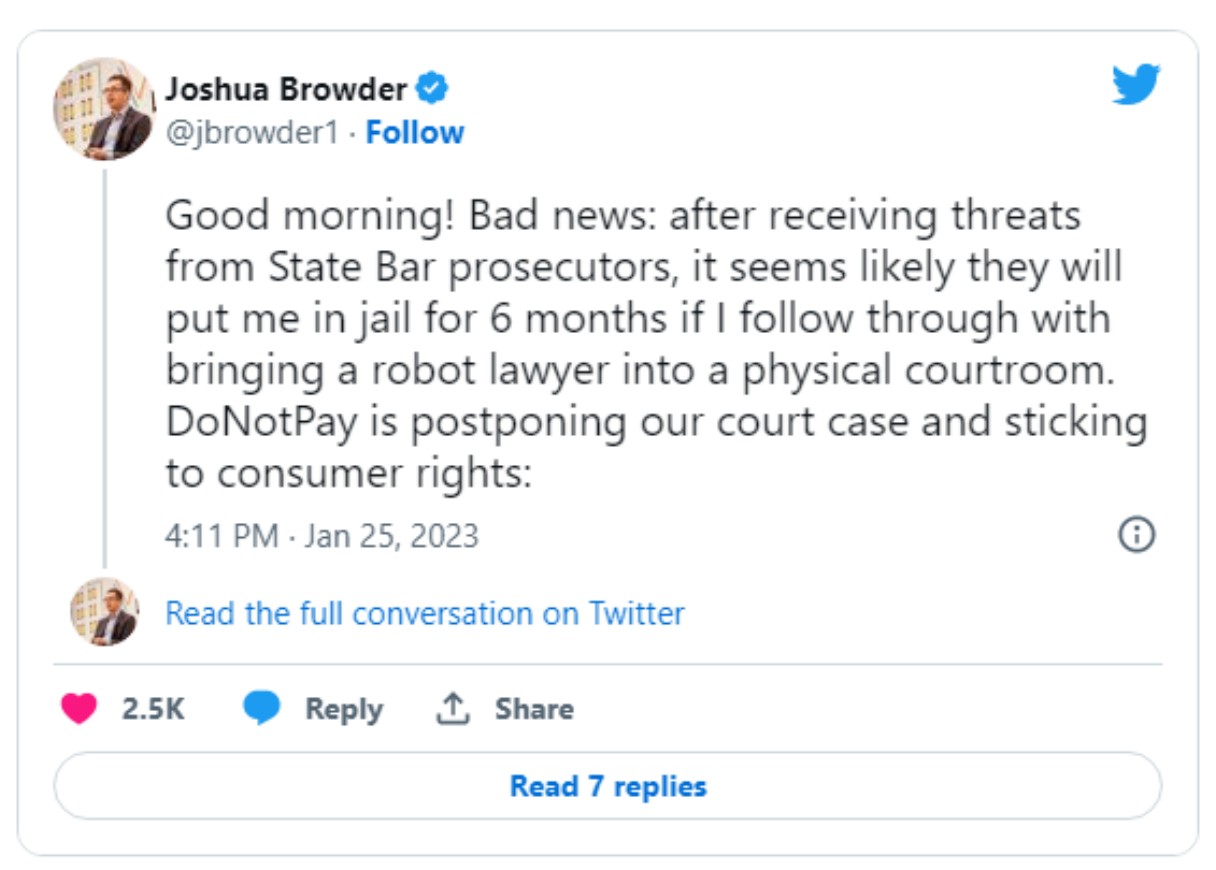

Nel gennaio 2023, l’azienda ha annunciato che la sua IA avrebbe agito come un “avvocato” informale in tribunale, aiutando il cliente nel ricorso contro una multa per eccesso di velocità.

“Il mese prossimo un programma addestrato con l’ausilio dell’intelligenza artificiale aiuterà un imputato ad esporre il proprio caso in un tribunale degli Stati Uniti… Invece di rivolgersi alla corte, il programma, che funzionerà su uno smartphone, fornirà risposte appropriate attraverso un auricolare all’imputato, che potrà poi utilizzarle in aula“.

Poiché si tratta del primo caso per l’IA, DoNotPay è pronta ad assumersi l’onere della sanzione se i consigli dell’IA non aiuteranno il cliente. Trattandosi di una multa per eccesso di velocità, DoNotPay pagherà la multa. Se vincerà, però, avrà una grande vittoria al suo attivo“. L’intelligenza artificiale avrebbe dovuto assistere il cliente in tribunale nel febbraio 2023. Ma poi non lo ha fatto.

Qui la conversazione completa su Twitter

Successivamente l’azienda è stata citata in giudizio per “aver praticato l’avvocatura senza licenza”. “L’avvocato robot sta affrontando una proposta di causa collettiva presentata dallo studio legale Edelson di Chicago e pubblicata sul sito web della Corte Superiore dello Stato della California per la Contea di San Francisco“.

A me sembra che la versione dell’IA rivolta alle persone e a basso prezzo sia vista come una minaccia dai grandi, che vogliono quindi porvi fine. Insomma, riuscite a immaginare un mondo in cui i contadini ignoranti utilizzano prodotti di IA (calcolatori veloci) a basso prezzo per aiutarsi da soli – e possibilmente anche senza inviare tutti i loro dati personali alla Nave Madre Centrale? Che oltraggio…

“Ross”

Un altro prodotto di IA, anch’esso bollato come “il primo avvocato artificialmente intelligente, è stato Ross”. “Ross” era il prodotto di IA realizzato da Ross Intelligence, una startup fondata nel 2014 da tre studenti canadesi. Il prodotto era basato sulla serie Watson di IBM di prodotti IA per le aziende. Fregatura: la società è stata chiusa nel 2020. Ecco quanto riportato da Futurism (2016):

“Lo studio legale Baker & Hostetler ha annunciato che sta impiegando l’IA Ross di IBM per gestire il proprio studio specializzato nella gestione dei fallimenti, attualmente composto da quasi 50 avvocati. Secondo l’amministratore delegato e cofondatore Andrew Arruda, anche altri studi hanno firmato licenze con Ross e faranno annunci a breve.

Ross, “il primo avvocato artificialmente intelligente al mondo”, costruito sulla base del computer cognitivo Watson di IBM, è stato progettato per leggere e comprendere il linguaggio, formulare ipotesi quando gli vengono poste delle domande, fare ricerche e quindi generare risposte (insieme a riferimenti e citazioni) a sostegno delle sue conclusioni. Ross impara anche dall’esperienza, acquisendo velocità e conoscenza quanto più si interagisce con lui”.

Ma, come ho detto, nel 2020 la Ross Intelligence è stata chiusa. A quanto pare non si trattava di questioni filosofiche legate all’uso dell’IA in campo legale, ma della concorrenza aziendale. Si trattava più che altro della lotta tra le folle e della questione di chi potesse beneficiare della potenziale cascata di dollari.

La società è stata chiusa in seguito al blocco dei finanziamenti a seguito della causa intentata da Thompson Reuters, che sosteneva che Ross Intelligence avesse utilizzato i dati di TR per costruire la propria IA legale.

“ROSS Intelligence, un’azienda che ha cercato di innovare la ricerca legale attraverso l’uso dell’intelligenza artificiale e che ha contribuito a sensibilizzare l’industria legale sull’IA, sta chiudendo le sue attività, poiché una causa intentata contro di lei da Thomson Reuters ha paralizzato la sua capacità di raccogliere nuovi finanziamenti o di esplorare potenziali acquisizioni, lasciandola senza fondi sufficienti per operare.

Thomson Reuters ha citato ROSS in giudizio a maggio, sostenendo che ha rubato contenuti da Westlaw per creare un proprio prodotto di ricerca legale concorrente. ROSS lo ha fatto, secondo TR, inducendo “intenzionalmente e consapevolmente” la società di ricerca e scrittura legale LegalEase Solutions a utilizzare il suo account Westlaw per fornire in massa i dati Westlaw a ROSS”.

Il proprietario dell’intelligenza artificiale stabilisce come usarla

Come sempre, il diavolo si nasconde nei dettagli. Se la tecnologia dell’IA viene utilizzata per aiutare le persone normali a svolgere i compiti che in precedenza erano fuori portata senza essere ricchi – e senza che i dati vengano trasmessi alla nave madre centrale – potrebbe essere una cosa utile.

E questo sarà il punto di forza durante le fasi iniziali del lancio della tecnologia. L’esca dovrebbe avere un buon sapore, è così che funziona sempre.

Ma se nella nostra vita professionale di tutti i giorni si svilupperà un’abitudine collettiva all’uso di chatbot e di calcolatori veloci dal suono coerente e dalla lingua chiara potrebbe succedere che, una volta ottenuta una quantità sufficiente di dati, le cose utili verranno spostate dietro un costoso “casello autostradale” (paywal)l. E forse, a quel punto, gli avvocati della classe media e persino della classe media superiore verranno “deprezzati”, proprio come molti sono stati “deprezzati” prima di loro. Il tempo ce lo dirà!

“Gradualmente e poi improvvisamente”: la conquista

Parliamo del concetto di esca. La vita lavora in modi misteriosi e la storia lavora in tempi lunghi. L’attacco all’agentività e alla personalità umana, al nostro rapporto con la natura e alla nostra ricchezza emotiva è iniziato migliaia di anni fa. Oggi abbiamo a che fare non solo con le intenzioni e le truffe incessanti di Klaus Schwab, degli alfabeti e dei loro proprietari ai piani alti, ma anche con le conseguenze delle truffe messe in atto dai tiranni e dagli imbroglioni del passato.

Oggi paghiamo il prezzo non solo per le imperfette scelte collettive delle persone sotto lo stivale dei grandi tiranni di oggi (compreso il nostro) – ma anche per le scelte imperfette fatte dalle vittime dei tiranni del passato, quando alcune persone sono state forse spaventate, o prepotenti, o ingannate, o corrotte per accettare i compromessi dell’anima del loro tempo.

E poi hanno trasmesso il compromesso ai loro figli. E lo hanno trasmesso ai loro figli. E così via. Vedete come funziona?

Anche su scala più piccola, funziona “gradualmente e poi improvvisamente”. Ad esempio, il modello di preparazione alle pandemie degli Stati Uniti, che ci ha colpito tutti nel 2020, è stato messo in moto all’inizio degli anni 2000, sotto la presidenza Bush. Dopo essere stato preparato, è rimasto lì nascosto dietro i cespugli (un gioco di parole! bush vuol dire cespuglio, N.d.T.) per 15 anni, in attesa di entrare in scena. E poi è entrata in scena come per rivalsa. Ed eccoci qui!

La condanna del modello algoritmico

Tutti questi sviluppi dell’intelligenza artificiale possono essere un omaggio alle capacità della tecnologia, ma sono anche una condanna dello stato della nostra civiltà.

Ricordate la domanda che ho posto all’inizio? Ho chiesto: qual è lo scopo del nostro tempo sulla Terra? E cosa stiamo facendo con la nostra civiltà se le nostre vite sono così meccaniche che persino una stupida calcolatrice veloce può svolgere il nostro “lavoro intellettuale” in modo più efficiente di noi? Qual è il nostro “lavoro”?

Ci hanno preso – gradualmente e poi improvvisamente -? I nostri modelli cognitivi “umani” e gli angoli da cui analizziamo il mondo sono diventati così algoritmici che una stupida macchina può superarci nel compito di “pensare”? Non va bene.

E, a proposito di legge, c’è stato un tempo nella storia – prima che le nostre comunità e le singole persone diventassero pedine invisibili sotto varie entità dominanti – in cui anche la “legge e l’ordine” non erano algoritmici, ma si basavano sul desiderio soggettivo e onesto di fare ciò che è giusto in senso spirituale.

E credo che a livello locale a volte succeda ancora, ma la mentalità del “dominio” ha avvelenato le nostre menti e l’algoritmo è stato messo in atto per mantenere una parvenza di bontà laddove la bontà era stata minata.

Credo che il ruolo esistenziale dell’orribile Grande Reset sia quello di rendere questo veleno algoritmico così grande, così evidente ai nostri occhi, che semplicemente non possiamo più negarlo e dobbiamo ribellarci all’antico abuso delle nostre anime. Perché noi siamo più di un insieme di formule. Siamo più che algoritmi.

Siamo fatti di spirito e di acqua, abbiamo un’anima, siamo capaci di navigare nella soggettività e di prosperare in essa, possiamo sentire, toccare, amare, assaporare le nostre relazioni – e questo è il senso del nostro essere qui.

La sensazione stessa di essere vivi – il respiro e la pelle – è il motivo per cui siamo qui. E quando qualcuno cerca di ridurci ulteriormente a macchine pattern-matching, abbiamo il pieno diritto di dire “No”. Vorrei concludere questo articolo con una citazione tratta da un racconto di fantascienza che ho scritto nel 2019 (ho aggiunto solo una riga su una pandemia nel 2020):

“Per ottenere il controllo sull’economia e sui corpi umani, dovevano prima ottenere il controllo sul pensiero delle persone. Così crearono una forte spinta a spostare tutte le principali attività umane nel dominio digitale, poiché le impronte digitali erano inizialmente molto più facili da tracciare e monetizzare. Crearono delle sciocchezze e fecero in modo che la transizione sembrasse divertente.

Allo stesso tempo, hanno costruito forti relazioni con alcuni dei cittadini e delle organizzazioni più influenti dell’epoca. I leader tecnologici promettevano alle forze dell’ordine una facile sorveglianza e ai cittadini comuni l’accesso gratuito all’istruzione e all’intrattenimento. Tutti pensavano di fare un ottimo affare!

Hanno dato alle persone opportunità inedite di creare nuovi mondi – sia dal lato degli sviluppatori che da quello degli utenti – ma nessuno, a parte i dirigenti, sapeva che i nuovi mondi erano accompagnati da tracciatori nascosti e da infidi interruttori on-off che era possibile attivare in qualsiasi momento.

I primi avvertimenti sono arrivati dagli artisti che avevano capito che il loro lavoro veniva usato come esca per attirare le persone sulle piattaforme tecnologiche. Ma gli artisti non sono membri rispettati della società e le loro grida furono soffocate da discorsi ottimistici sul futuro brillante di tutto.

Poi arrivarono i media. Dopo che le aziende giornalistiche ebbero iniziato a crollare e molti giornalisti si trovarono senza un reddito, capirono che il gioco era truccato. Ma anche loro furono stati spazzati via. Alcuni fecere un affare e accettarono finanziamenti tecnologici, altri divennero lavoratori della “gig economy” e altri ancora impararono a scrivere software.

Infine, in un momento critico, ci fu una specie di pandemia e i potenti leader della tecnologia, compresi alcuni dei santi ufficiali dell’IHT, riuscirono a usare la loro influenza sui governi per imporre legalmente la digitalizzazione di tutti gli aspetti della vita. È fu allora che il contatto umano non regolamentato venne reso illegale e i dispositivi indossabili intelligenti e gli assistenti IA divennero obbligatori”.

Quando avvocati, medici, banchieri e funzionari governativi furono colpiti personalmente e praticamente schiavizzati su vasta scala, era ormai troppo tardi. Le Big Tech controllavano ogni aspetto della vita, tracciavano tutto e finanziavano ogni industria. Erano diventate i corpo di polizia predefinito e l’editore di notizie predefinito, e quindi avevano il potere di fare o disfare qualsiasi opinionista, accademico o politico.

Tutti, dai governi agli assistenti di basso livello ai robot, dipendevano dalla tecnologia per ogni funzione della vita. I permessi sessuali e per la nascita di bambini richiedevano punteggi impeccabili di Cittadino Digitale. Nessuno poteva ottenere un lavoro di basso livello senza attenersi agli algoritmi, e la maggior parte dei lavori era comunque automatizzata. I comuni dovevano soldi per la manutenzione delle città intelligenti. La morsa era totale.

E se da un lato molti si sentivano istintivamente a disagio nel rinunciare alla privacy e all’autonomia cognitiva, dall’altro si sentivano soli e indifesi. I posti di lavoro al di fuori del settore tecnologico erano scarsi, la concorrenza era dura e pochi avevano il lusso di riflettere sul quadro generale. Quindi le persone tenevano la testa bassa e facevano quello che dovevano fare per sfamare le loro famiglie: si adeguavano, indossavano mascherine intelligenti obbligatorie e imparavano a scrivere software, se era loro consentito.

Gli sviluppatori e gli altri lavoratori di alto livello dell’industria tecnologica conservarono più a lungo la loro indipendenza finanziaria e la loro autonomia cognitiva – le comunità recintate di softwaristi divennero un punto fermo in ogni nodo urbano intelligente – ma alla fine anche loro sono divennero obsoleti, poiché l’intelligenza artificiale era diventata abbastanza sofisticata da produrre se stessa.

Poco dopo fu deprecata l’istituzione di una governance biologicamente compromessa e la Big Tech si trasformò Interplanetary Holy Tech, e il resto lo sapete”.

Vi suona familiare? Se è così, è un buon momento per tutti noi per riflettere sul perché siamo nati sulla Terra, sul perché siamo vivi qui e ora, con tutti i nostri doni – e per portare avanti i compiti unici, coraggiosi e importanti che siamo qui a svolgere. Con il cuore.

![tessa_lena]() Tessa Lena è un’artista dello spettacolo, un’immigrata newyorkese con una drammatica storia di sopravvivenza. La sua missione è creare un cambiamento sociale avvicinando le persone e aiutando i membri della comunità ad attingere alla forza interiore e a parlare tra loro per superare i disaccordi. Ha viaggiato in tutto il mondo, ha fatto ricerca accademica in Tibet, ha suonato al Conservatorio di Mosca, ha lavorato come sviluppatrice presso Blue Cross and Blue Shield, ha scritto di tecnologia, ha combattuto un trafficante di sesso in Cina.

Tessa Lena è un’artista dello spettacolo, un’immigrata newyorkese con una drammatica storia di sopravvivenza. La sua missione è creare un cambiamento sociale avvicinando le persone e aiutando i membri della comunità ad attingere alla forza interiore e a parlare tra loro per superare i disaccordi. Ha viaggiato in tutto il mondo, ha fatto ricerca accademica in Tibet, ha suonato al Conservatorio di Mosca, ha lavorato come sviluppatrice presso Blue Cross and Blue Shield, ha scritto di tecnologia, ha combattuto un trafficante di sesso in Cina.

Link: https://articles.mercola.com/sites/articles/archive/2023/04/22/are-ai-lawyers-coming-for-us.aspx

Scelto e tradotto (IMC) da CptHook

CANALE YOUTUBE: https://www.youtube.com/@ComeDonChisciotte2003

CANALE RUMBLE: https://rumble.com/user/comedonchisciotte

CANALE ODYSEE: https://odysee.com/@ComeDonChisciotte2003

CANALI UFFICIALI TELEGRAM:

Principale - https://t.me/comedonchisciotteorg

Notizie - https://t.me/comedonchisciotte_notizie

Salute - https://t.me/CDCPiuSalute

Video - https://t.me/comedonchisciotte_video

CANALE UFFICIALE WHATSAPP:

Principale - ComeDonChisciotte.org